Если речь о физическом толковании, то информацию часто связывают с понятием "энтропия" - мера хаоса. Что это такое можно узнать из второго закона термодинамики. Процессы нашего мира протекают с увеличением энтропии. Так задаётся направление движения времени для нас.

Как это связано с информацией? "Что-то" содержит тем больше информации, чем более это "что-то" хаотично. Например, 0100010001000100 можно представить как repeat(0100, 4), а 1001110100010101011 представить таким образом уже сложнее. Чем более "несжимаема" информация, тем больше этой информации. В первом случае, мы выделили паттерн, который описывает всё последовательность. Во втором случае мы этого сделать не смогли. Но паттерн также является частью информации, также несёт информацию. Поэтому для нас ценны не абсолютно информативные сообщения (белый шум), а нечто промежуточное между примитивной информацией и невоспринимаемо сложной.

Понятия энтропия и информация связаны друг с другом. Но энтропия - лишь мера, она не может существовать "сама по себе". Энтропия существует при приложении к веществу и энергии. Вещество и энергия выступают хранилищем и переносчиком информации, взаимодействия - физические представления информации в мире.

Саму информацию можно понимать как абстрактное понятие, а вещество и энергию - как инструменты представления и передачи информации.

Число в двоичной системе счисления выглядит как единица и n нулей за ней.

То есть у числа ровно 1533 значащих нуля, а у числа их ровно 1022.

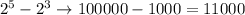

Разница же таких чисел порождает единицы между первыми единицами изначальных чисел. Например, . Появилось 5-3 = 2 единицы и осталось 3 (от последнего числа) значащих нуля.

Зная это, мы можем разобраться, сколько значащих нулей в загаданном числе.

даёт нам 1022 значащих 0 и 511 единиц перед ними.

даёт нам 9 значащих 0 и 502 единицы перед ними.

даёт нам 0 значащих 0 и 1 единицу перед ними (просто единица).

Теперь сложение.

Начинаем с самых больших разрядов. Понижаясь, вычитаем количество образовавшихся в середине единиц.

Если речь о физическом толковании, то информацию часто связывают с понятием "энтропия" - мера хаоса. Что это такое можно узнать из второго закона термодинамики. Процессы нашего мира протекают с увеличением энтропии. Так задаётся направление движения времени для нас.

Как это связано с информацией? "Что-то" содержит тем больше информации, чем более это "что-то" хаотично. Например, 0100010001000100 можно представить как repeat(0100, 4), а 1001110100010101011 представить таким образом уже сложнее. Чем более "несжимаема" информация, тем больше этой информации. В первом случае, мы выделили паттерн, который описывает всё последовательность. Во втором случае мы этого сделать не смогли. Но паттерн также является частью информации, также несёт информацию. Поэтому для нас ценны не абсолютно информативные сообщения (белый шум), а нечто промежуточное между примитивной информацией и невоспринимаемо сложной.

Понятия энтропия и информация связаны друг с другом. Но энтропия - лишь мера, она не может существовать "сама по себе". Энтропия существует при приложении к веществу и энергии. Вещество и энергия выступают хранилищем и переносчиком информации, взаимодействия - физические представления информации в мире.

Саму информацию можно понимать как абстрактное понятие, а вещество и энергию - как инструменты представления и передачи информации.

Число в двоичной системе счисления выглядит как единица и n нулей за ней.

в двоичной системе счисления выглядит как единица и n нулей за ней.

То есть у числа ровно 1533 значащих нуля, а у числа

ровно 1533 значащих нуля, а у числа  их ровно 1022.

их ровно 1022.

Разница же таких чисел порождает единицы между первыми единицами изначальных чисел. Например, . Появилось 5-3 = 2 единицы и осталось 3 (от последнего числа) значащих нуля.

. Появилось 5-3 = 2 единицы и осталось 3 (от последнего числа) значащих нуля.

Зная это, мы можем разобраться, сколько значащих нулей в загаданном числе.

Теперь сложение.

Начинаем с самых больших разрядов. Понижаясь, вычитаем количество образовавшихся в середине единиц.

1022 - 502 - 1 = 519 - ответ.